引用次数在1.5w次以上神仙论文!

MLNLP社区是国内外知名的机器学习与自然语言处理社区,受众覆盖国内外NLP硕博生、高校老师以及企业研究人员。

社区的愿景是促进国内外自然语言处理,机器学习学术界、产业界和广大爱好者之间的交流和进步,特别是初学者同学们的进步。转载自 | Datawhale内容 | 经典论文编辑 | 数据派THU

前言

小编在这里总结梳理了知乎上“引用次数在15000次以上的都是什么论文?”这一问题的经典回答,希望能帮助到各位进一步了解领域内的相关进展,并且通过阅读这些经典论文或许也会给您带来不少启发。

1. 机器学习领域

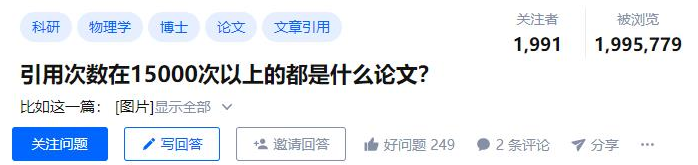

我来列举一些机器学习(Machine Learning)领域的高被引文章。机器学习领域泰斗级学者Geoffrey Hinton的文章引用: 引用次数超过15000次文章有:

引用次数超过15000次文章有:

- ImageNet Classification with Deep Convolutional Neural Networks,引用75231次(AlexNet,点燃了深度学习的热潮,因此2012年被认为是深度学习元年,当然要十分感谢ImageNet和GPU的加持);

- Learning internal representations by error-propagation & Learning representations by back-propagating errors,引用50716次(BP算法,殿堂级别的成果,几乎所有关于神经网络的文章都会用到BP算法);

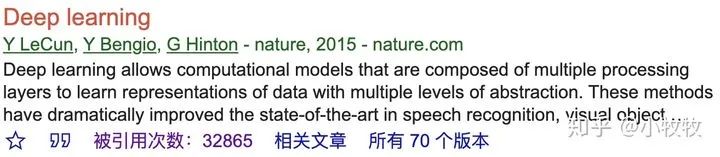

- Deep learning,引用33222次(“三巨头”关于深度学习的综述文章);

- Dropout: a simple way to prevent neural networks from overfitting,引用24452次(Dropout是一种防止深度学习模型过拟合的正则化方法,目前已被Google申请专利,面对封锁,华为诺亚实验室开源了Disout算法,直接对标Google的Dropout);

- Visualizing data using t-SNE,引用16957次(t-SNE是一种流形学习方法,用于数据降维和可视化)。

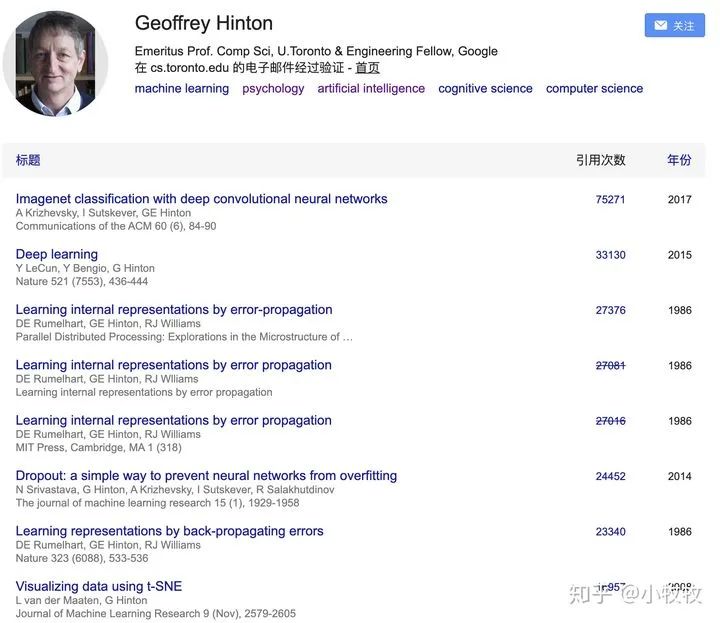

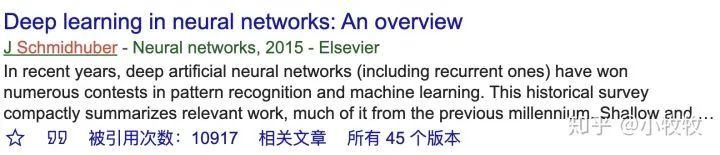

Geoffrey Hinton谷歌学术引用次数在机器学习领域还有一个泰斗级的人物Jürgen Schmidhuber,他的一篇文章Long short-term memory目前的引用量是40934次,是深度学习-循环神经网络(Recurrent Neural Network, RNN)中的重要成果。但是LeCun Y,Bengio Y和Hinton G在2015年发表在Nature上的文章Deep learning作者中没有Jürgen Schmidhuber,不过Schmidhuber在2015也发表了一篇关于深度学习的综述文章Deep learning in neural networks: An overview,目前的引用量是10917。

Geoffrey Hinton谷歌学术引用次数在机器学习领域还有一个泰斗级的人物Jürgen Schmidhuber,他的一篇文章Long short-term memory目前的引用量是40934次,是深度学习-循环神经网络(Recurrent Neural Network, RNN)中的重要成果。但是LeCun Y,Bengio Y和Hinton G在2015年发表在Nature上的文章Deep learning作者中没有Jürgen Schmidhuber,不过Schmidhuber在2015也发表了一篇关于深度学习的综述文章Deep learning in neural networks: An overview,目前的引用量是10917。

机器学习领域还有一些重要的成果,对应的文章也有不俗的引用量。比如:

机器学习领域还有一些重要的成果,对应的文章也有不俗的引用量。比如:

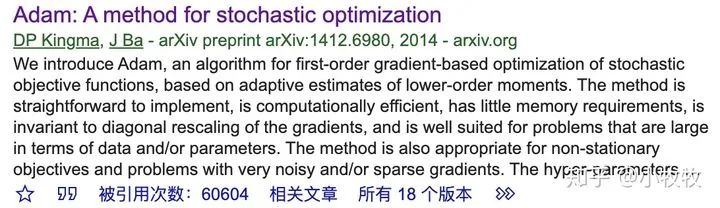

- 一直被对比,从未被超越的Adam,目前的引用量是60604次;

- 使神经网络训练更快、更稳定的Batch normalization,目前的引用量是22986次;

- 避免深层网络训练时梯度消失或梯度爆炸的激活函数—线性整流函数ReLU(Rectified linear units improve restricted boltzmann machines),目前的引用量是11548次。

- Zisserman在2014年发表的关于VGGNet的文章Very deep convolutional networks for large-scale image recognition,目前的引用量是48691次。Google在2015年发表的关于GoogLeNet的文章Going deeper with convolutions,目前的引用量是26353次。何凯明2016年的文章Deep residual learning for image recognition,提出的多达152层ResNet,目前的引用量是63253次。2016年提出的用于目标检测的Faster R-CNN,目前的引用量是24215次。

来源:小牧牧(知乎)

来源:小牧牧(知乎)

https://www.zhihu.com/question/433702668/answer/1617092684

2. 计算机视觉领域

这里重点盘点一下AI领域,特别是CV方向的论文。值得说一下,自从2012年,特别是2014年后,AI领域再度火爆,延续至今,很多优秀论文(特别是基于深度学习)也是发表在这个期间,引用量也迅速爆炸。

- 注:下面会边介绍作者,边介绍论文,侧重点有点不同。

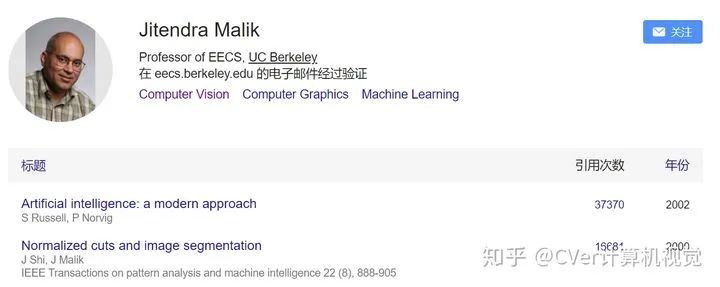

计算机视觉领域引用量1.5万+的论文Andrew Zisserman(传闻欧洲计算机视觉第一人)第一篇引用量近5万的是:深度学习时代的经典backbone模型VGG:Very deep convolutional networks for large-scale image recognition第二篇引用量近3万,这其实是一本书《Multiple view geometry in computer vision》,可称为深度学习时代前的CV必读之作(现在其实也强推,但不少新入坑CV的人,直接跳过这些基础知识,去玩CNN了)Jitendra Malik 加州大学伯克利分校的电子工程与计算机科学系(EECS)教授 Jitendra Malik获颁 2019 年 IEEE 计算机先驱奖。第一篇引用量近4万,算是12年之前人工智能最经典的书籍,内容覆盖范围相当之广。不过Jitendra Malik并非一二作,所以搜索该书的时候,不容易看到他的名字。第二篇引用量近1.7万,基于传统方法的图像分割代表作!下面说说深度学习三巨头(Hinton、Bengio和LeCun)Geoffrey HintonHinton的代表作太多了,1.5万+引用量的论文见下图(6篇)。比如

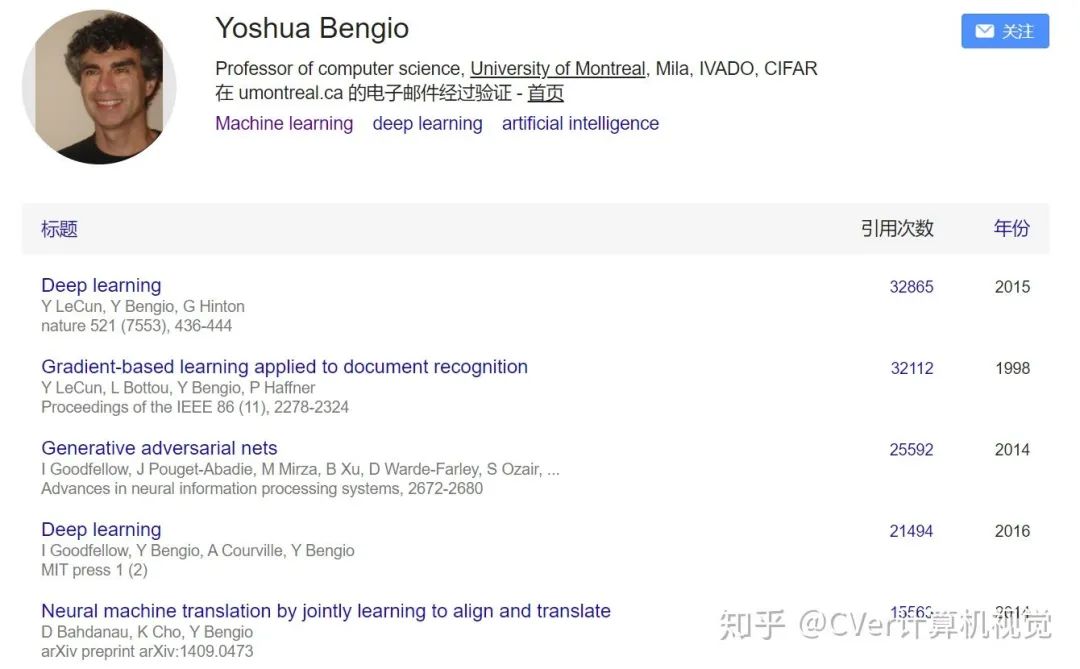

加州大学伯克利分校的电子工程与计算机科学系(EECS)教授 Jitendra Malik获颁 2019 年 IEEE 计算机先驱奖。第一篇引用量近4万,算是12年之前人工智能最经典的书籍,内容覆盖范围相当之广。不过Jitendra Malik并非一二作,所以搜索该书的时候,不容易看到他的名字。第二篇引用量近1.7万,基于传统方法的图像分割代表作!下面说说深度学习三巨头(Hinton、Bengio和LeCun)Geoffrey HintonHinton的代表作太多了,1.5万+引用量的论文见下图(6篇)。比如 第一篇引用量7.5万+,发表于2012年的AlexNet!永远滴神!第二篇引用量3.3万+,是为了纪念人工智能60周年,深度学习三巨头合作在Nature上发表深度学习的综述性文章:Deep Learning还有4篇破1.5万引用量的论文,这里不赘述,膜拜即可!Yoshua BengioBengio教授的代表作也太多了,1.5万+引用量的论文见下图(5篇)。比如:

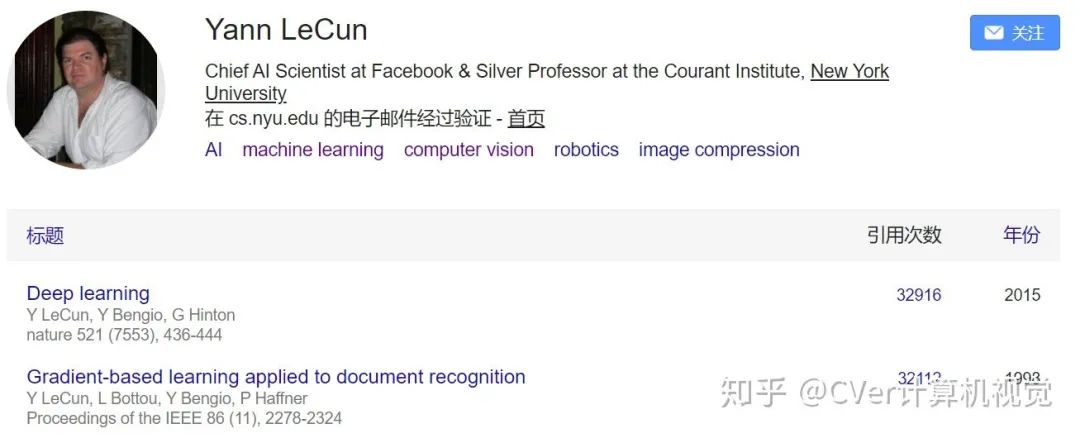

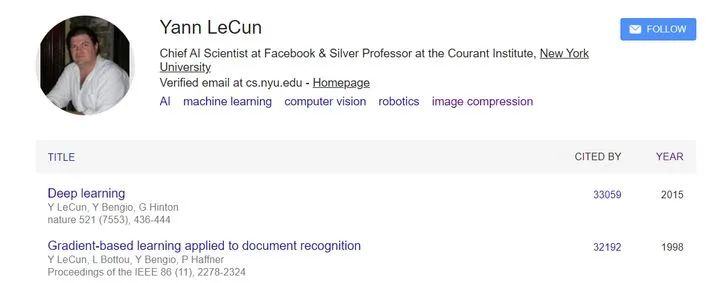

第一篇引用量7.5万+,发表于2012年的AlexNet!永远滴神!第二篇引用量3.3万+,是为了纪念人工智能60周年,深度学习三巨头合作在Nature上发表深度学习的综述性文章:Deep Learning还有4篇破1.5万引用量的论文,这里不赘述,膜拜即可!Yoshua BengioBengio教授的代表作也太多了,1.5万+引用量的论文见下图(5篇)。比如: 第一篇上面说过了,是深度学习三巨头合著的。第二篇引用量3万+,这是和LeCun提出了当时风靡一时的字符识别器(当时就是典型落地应用)第三篇引用量2.5万+,这是和Goodfellow提出了鼎鼎大名的GAN!第四篇引用量2万+,这是和Goodfellow发布了深度学习时代的"圣经"书籍:Deep Learning,国内不少人又称为花书。Yann LeCunLeCun大佬的两篇破1.5万的工作,上面已经介绍了。

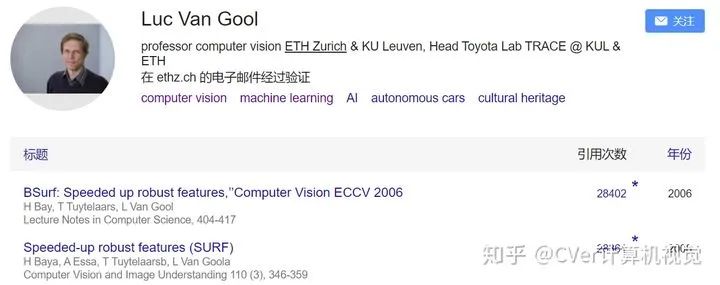

第一篇上面说过了,是深度学习三巨头合著的。第二篇引用量3万+,这是和LeCun提出了当时风靡一时的字符识别器(当时就是典型落地应用)第三篇引用量2.5万+,这是和Goodfellow提出了鼎鼎大名的GAN!第四篇引用量2万+,这是和Goodfellow发布了深度学习时代的"圣经"书籍:Deep Learning,国内不少人又称为花书。Yann LeCunLeCun大佬的两篇破1.5万的工作,上面已经介绍了。 Luc Van GoolLuc Van Gool 苏黎世联邦理工学院教授,据了解,有若干中国学生曾师从于他。这篇近3万引用量就是非常著名的SURF算法。

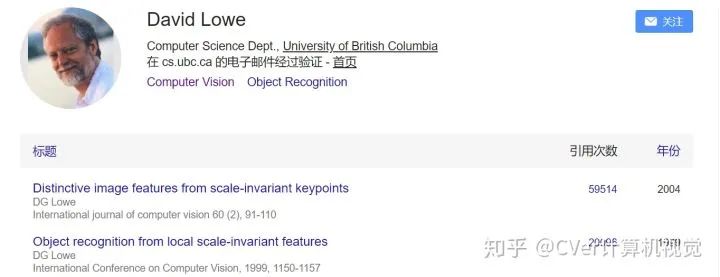

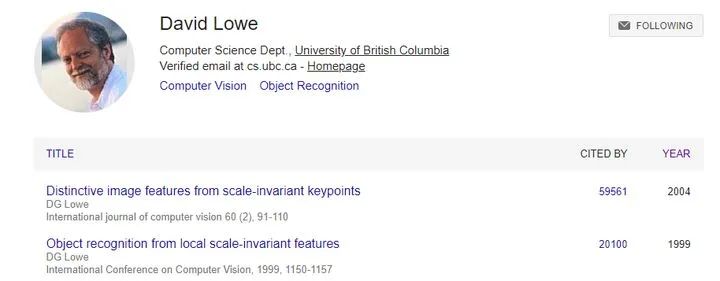

Luc Van GoolLuc Van Gool 苏黎世联邦理工学院教授,据了解,有若干中国学生曾师从于他。这篇近3万引用量就是非常著名的SURF算法。 上面提到SURF算法,就不得不提SIFT算法。David Lowe

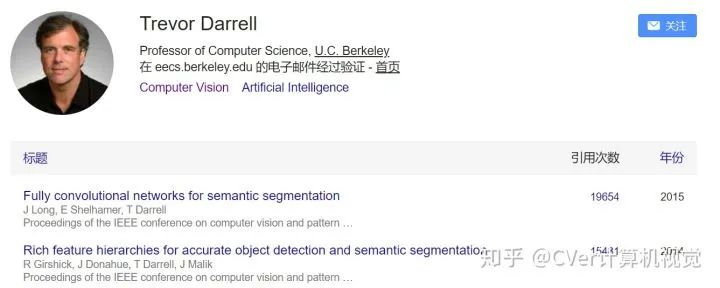

上面提到SURF算法,就不得不提SIFT算法。David Lowe SIFT算法引用量近6万!其是手工特征时代的最具代表性工作!SURF、ORB在它面前都是弟弟,截止目前SIFT仍被广泛应用,相当能打!Trevor Darrell第一篇引用量近2万,鼎鼎大名的基于FCN的语义分割网络!第二篇引用量1.5万+,鼎鼎大名的R-CNN目标检测网络。

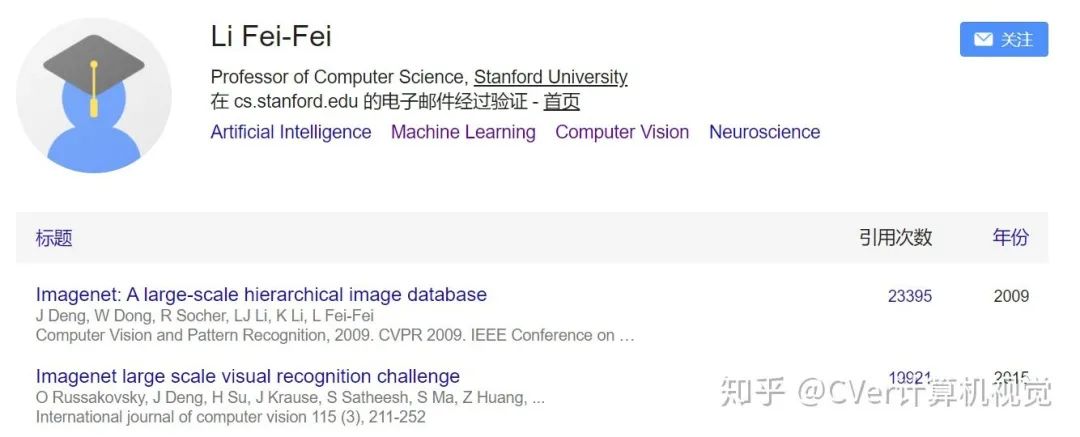

SIFT算法引用量近6万!其是手工特征时代的最具代表性工作!SURF、ORB在它面前都是弟弟,截止目前SIFT仍被广泛应用,相当能打!Trevor Darrell第一篇引用量近2万,鼎鼎大名的基于FCN的语义分割网络!第二篇引用量1.5万+,鼎鼎大名的R-CNN目标检测网络。 李飞飞(Li Fei-Fei)李飞飞女神,创建了ImageNet数据集和相关赛事~ 影响力巨大。

李飞飞(Li Fei-Fei)李飞飞女神,创建了ImageNet数据集和相关赛事~ 影响力巨大。 上述主要是AI、CV领域的大前辈(年龄基本40+),这里重点介绍几位"新秀":何恺明(Kaiming He)做CV的应该都听过何恺明,有鼎鼎大名的ResNet、Faster R-CNN、Mask R-CNN、Focal Loss、FPN和近期的MoCo等工作。

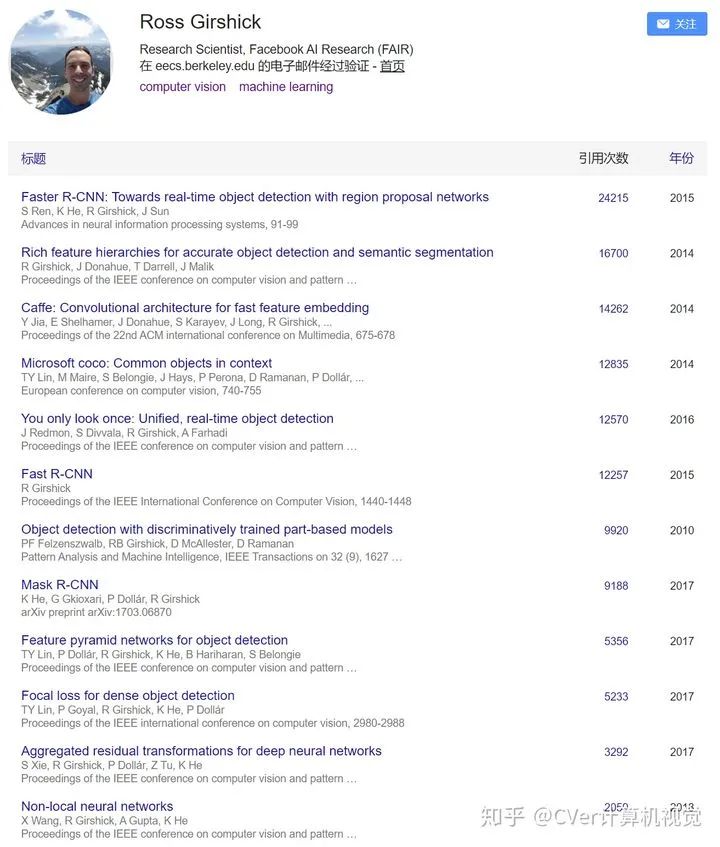

上述主要是AI、CV领域的大前辈(年龄基本40+),这里重点介绍几位"新秀":何恺明(Kaiming He)做CV的应该都听过何恺明,有鼎鼎大名的ResNet、Faster R-CNN、Mask R-CNN、Focal Loss、FPN和近期的MoCo等工作。 第一篇是目前CV主流使用的backbone:ResNet,永远滴神!第二篇是目标检测领域代表性网络:Faster R-CNN。估计17年发表的Mask R-CNN 也快破1.5万引用量了。Ross Girshick他与何恺明算是合作搭档,都在FAIR工作,有不少合作的工作。有鼎鼎大名的R-CNN系列工作,合作的有Caffe、Mask R-CNN、Focal Loss、FPN和YOLO等工作。

第一篇是目前CV主流使用的backbone:ResNet,永远滴神!第二篇是目标检测领域代表性网络:Faster R-CNN。估计17年发表的Mask R-CNN 也快破1.5万引用量了。Ross Girshick他与何恺明算是合作搭档,都在FAIR工作,有不少合作的工作。有鼎鼎大名的R-CNN系列工作,合作的有Caffe、Mask R-CNN、Focal Loss、FPN和YOLO等工作。 Ian GoodfellowGAN 之父!下面三个工作都是目前顶级活跃的,比如GAN、Deep Learning书籍和TensorFlow框架。

Ian GoodfellowGAN 之父!下面三个工作都是目前顶级活跃的,比如GAN、Deep Learning书籍和TensorFlow框架。 任少卿(Shaoqing Ren)Faster R-CNN一作!貌似现在不做研究了,主要在企业(目前在蔚来)担任技术主管/副总裁。

任少卿(Shaoqing Ren)Faster R-CNN一作!貌似现在不做研究了,主要在企业(目前在蔚来)担任技术主管/副总裁。 其实CV领域还有很多超1.5万的论文,限于篇幅这里就不一一盘点:

其实CV领域还有很多超1.5万的论文,限于篇幅这里就不一一盘点: 作者:BeyondSelf(知乎)https://www.zhihu.com/question/433702668/answer/1624083551

作者:BeyondSelf(知乎)https://www.zhihu.com/question/433702668/answer/1624083551

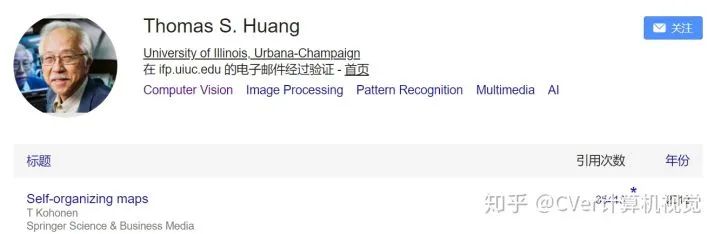

3. 通信和图像处理

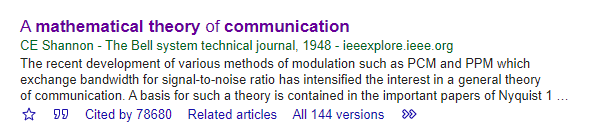

梳理一下通信和图像处理方面,读过的一些经典的,超过15000引用的论文。1. A Mathematical theory of communication 引用次数:78680评价:开创了信息论,直接奠定了通信的发展,大名鼎鼎的香农三定理和熵的概念就是在这篇文章中提出的。没有它,就没有WiFi和5G,也没有我们刷着知乎听着歌2. A combined coerner and edge detector

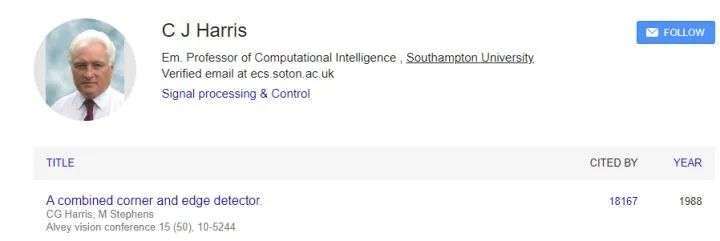

引用次数:78680评价:开创了信息论,直接奠定了通信的发展,大名鼎鼎的香农三定理和熵的概念就是在这篇文章中提出的。没有它,就没有WiFi和5G,也没有我们刷着知乎听着歌2. A combined coerner and edge detector 引用次数:18167评价:提出了角点特征,能够检测图片中的角点、边缘和图片。是图像特征提取的代表作,是图像分割、匹配等的基础。3. Distinctive image features from scale-invariant keypoints

引用次数:18167评价:提出了角点特征,能够检测图片中的角点、边缘和图片。是图像特征提取的代表作,是图像分割、匹配等的基础。3. Distinctive image features from scale-invariant keypoints 引用次数:59561评价:大名鼎鼎的SIFT特征,具有尺度、方向、仿射不变性,和上一篇论文的Haris特征一起,成为图像特征提取的两个最重要技术。4. Object recognition from local scale-invariant features引用次数:20100评价:David Lowe的另一篇文章,说的是利用尺度不变特征来进行目标识别5. Compressed Sensing引用次数:27557评价:压缩感知的代表作之一,将采样和压缩过程结合起来同时进行,直接对信号的稀疏性进行感知。6. Robust Uncertainty Principles: Exact Signal Reconstruction From Highly Incomplete Frequency Information引用次数:16700评价:压缩感知的另一篇代表作7. A new approach to linear filtering and prediction problems引用次数:35070评价:提出了著名的卡尔曼滤波。如果你没听说过卡尔曼滤波不要仅,但你一定点过外卖,打过滴滴,甚至美国阿波罗号上天也用过它,根据测量值和状态方程修正真实值,就是它干的事情,8. A computational approach to edge detection引用次数:35942评价:边缘检测的另一篇代表作9. Gradient-based learning applied to document recognition

引用次数:59561评价:大名鼎鼎的SIFT特征,具有尺度、方向、仿射不变性,和上一篇论文的Haris特征一起,成为图像特征提取的两个最重要技术。4. Object recognition from local scale-invariant features引用次数:20100评价:David Lowe的另一篇文章,说的是利用尺度不变特征来进行目标识别5. Compressed Sensing引用次数:27557评价:压缩感知的代表作之一,将采样和压缩过程结合起来同时进行,直接对信号的稀疏性进行感知。6. Robust Uncertainty Principles: Exact Signal Reconstruction From Highly Incomplete Frequency Information引用次数:16700评价:压缩感知的另一篇代表作7. A new approach to linear filtering and prediction problems引用次数:35070评价:提出了著名的卡尔曼滤波。如果你没听说过卡尔曼滤波不要仅,但你一定点过外卖,打过滴滴,甚至美国阿波罗号上天也用过它,根据测量值和状态方程修正真实值,就是它干的事情,8. A computational approach to edge detection引用次数:35942评价:边缘检测的另一篇代表作9. Gradient-based learning applied to document recognition 引用次数:32192评价:LeCun的经典论文,做过机器学习的都知道,没做过机器学习的也一般听说过MNIST数据集来源:远处群山(知乎)https://www.zhihu.com/question/433702668/answer/1622573162

引用次数:32192评价:LeCun的经典论文,做过机器学习的都知道,没做过机器学习的也一般听说过MNIST数据集来源:远处群山(知乎)https://www.zhihu.com/question/433702668/answer/1622573162

4. 信号处理和图像处理

引用一万五千次以上的论文相当罕见,基本上都属于开山之作,开创了某个中等或者大领域的作品。现在深度学习的论文里15000次引用的挺多的,看到也有其他答主总结了,我就重点说下信号处理和图像处理的经典论文,压缩感知的两篇开山之作:

- Donoho D L. Compressed sensing[J]. IEEE Transactions on information theory, 2006, 52(4): 1289-1306. 27000次引用

- Candès E J, Romberg J, Tao T. Robust uncertainty principles: Exact signal reconstruction from highly incomplete frequency information[J]. IEEE Transactions on information theory, 2006, 52(2): 489-509. 16000次引用

统计学习里大名鼎鼎的LASSO:

- Tibshirani R. Regression shrinkage and selection via the lasso[J]. Journal of the Royal Statistical Society: Series B (Methodological), 1996, 58(1): 267-288. 引用35000次

统计学习的圣典:

- Cortes C, Vapnik V. Support-vector networks[J]. Machine learning, 1995, 20(3): 273-297.

图像分割的开山之作normalized cut:

- Shi J, Malik J. Normalized cuts and image segmentation[J]. IEEE Transactions on pattern analysis and machine intelligence, 2000, 22(8): 888-905. 引用16000次

同样来自Malik老师的图像去噪神作——扩散滤波,威名赫赫的Perona-Malik模型,多少PDE-based image processing methods就是源自这里:

- Perona P, Malik J. Scale-space and edge detection using anisotropic diffusion[J]. IEEE Transactions on pattern analysis and machine intelligence, 1990, 12(7): 629-639. 引用15000次

图像去噪的又一神作,超级经典的全变差模型:

- Rudin L I, Osher S, Fatemi E. Nonlinear total variation based noise removal algorithms[J]. Physica D: nonlinear phenomena, 1992, 60(1-4): 259-268. 引用15000次

无比经典的SIFT图像特征检测以及方向梯度直方图(HOG)模型,做图像处理的应该没有不知道这两个的:

- Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International journal of computer vision, 2004, 60(2): 91-110. 58000次引用

- Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]//2005 IEEE computer society conference on computer vision and pattern recognition (CVPR'05). IEEE, 2005, 1: 886-893. 32000次引用

做图像恢复的人肯定都知道SSIM这个指标,出自这篇文章:

- Wang Z, Bovik A C, Sheikh H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE transactions on image processing, 2004, 13(4): 600-612. 引用27000

大家还知道哪些引用率超高的重量级文章呢?欢迎在留言区讨论!技术交流群邀请函

△长按添加小助手

扫描二维码添加小助手微信

请备注:姓名-学校/公司-研究方向(如:小张-哈工大-对话系统)即可申请加入自然语言处理/Pytorch等技术交流群

关于我们

MLNLP 社区是由国内外机器学习与自然语言处理学者联合构建的民间学术社区,目前已经发展为国内外知名的机器学习与自然语言处理社区,旨在促进机器学习,自然语言处理学术界、产业界和广大爱好者之间的进步。社区可以为相关从业者的深造、就业及研究等方面提供开放交流平台。欢迎大家关注和加入我们。

相关推荐

实时数仓的过去现在和未来

2023 年云计算的增长点在何处?

网传微软苏州裁员:赔偿N+12个月工资;ChatGPT将上线付费订阅;Win 10数字许可停售 | 极客头条

腾讯数据治理技术实践

一文揭晓,我是如何在 Linux 中查找自如

面试挂:请说说Java垃圾是怎么回收的?

腊月27日凌晨的一个紧急 Elasticsearch 线上问题复盘

面试官:说一下 GET 和 POST 最本质的区别?

SpringBoot巧用 @Async 提升API接口并发能力

谷歌裁员细节曝光:开源主管被裁,61岁程序员在线求职,有人60天找不到工作就被遣返

最好的SpringBoot系统!!!

使用 fcntl 模块对文件进行加解锁

ChatGPT全景图 | 产品+商业篇

别总写代码,这130个网站比涨工资都重要!

一男医生乱发女患者私密照;乳山部分海景房每平米跌破千元;韩国女子在驻韩美军基地被性侵;鱼跃医疗被罚270万元...|酷玩日爆

日本啤酒品牌的中国大溃败

美国又要对华为下黑手了,我们怎么办?

《狂飙》证明:影视剧里的坏人,其实教不坏观众

流浪地球周边到!2800+零件还原装甲车,科幻迷沸腾了!

双腿截肢黑人男子遭美警连开10枪身亡;英工人维修核潜艇时用胶水粘螺丝螺栓;美国拟追加20亿美元对乌军援 | 每日大新闻